Science : Prospective informatique 1

Chers lecteurs de ce blog (le s est-il vraiment nécessaire ?),

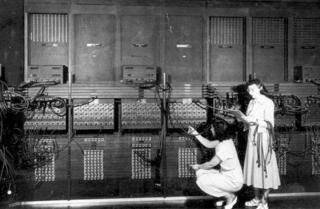

quelques billets pour vous faire part d'une conversation amusante que j'ai récemment eue avec mon directeur de thèse (il me faut préciser pour les potentiels lecteurs de ce blog qui ne sont pas de mes proches que je suis en toute fin de thèse de physique et que je soutiens le 16 Septembre. Ugh...). J'ai vu dans ma prime jeunesse tout au long des années 80 et 90 l'essor de l'informatique personnelle (je me souviens encore avec excitation et émotion du jour où mon père a ramené à la maison un TO7). Je croyais naivement qu'avant cette époque glorieuse, l'informatique -en France en tous cas- n'était reservée qu'à une élite fortunée et/ou militaire et que de gigantesques machines type Eniac (cf photo) calculaient jour et nuit d'obscures quantités liées à une potentielle guerre nucléaire. Que nenni ! L'informatique avait déjà fait depuis longtemps son entrée dans les labos de recherche. Mon directeur de thèse a même été l'un des tous premiers à taper sa thèse sur traitement de texte, à l'aide d'un concurrent aujourd'hui disparu de Tex. Pour l'anecdote, l'ordinateur du labo auxquel étaient reliés tous les terminaux occupait la totalité de la salle où travaillent actuellement les thésards (faut-il y voir une certaine continuité historique 8^) ? ). Plus surprenant, jusqu'à assez récemment, l'un des défis potentiels était de concevoir et de construire des ordinateurs pouvant résoudre spécifiquement des problèmes très précis donnés. Par exemple, un ordinateur pouvant calculer précisément des comportements liés aux transitions de phase (type eau-glace) , ou pouvant simuler très efficacement tel ou tel problème de physique des fluides. L'idée séduisante était d'optimiser l'architecture et les langages pour pouvoir commercialiser et utiliser au quotidien un super-ordinateur pouvant réaliser une opération très précise donnée.

Evidemment, ces projets très lourds et très couteux sont vite devenus caducs compte-tenu de la croissance exponentielle des capacités de calcul. Dès le début des années 90, n'importe quel PC du commerce écrabouillait de plusieurs ordres de grandeur en terme de puissance de calcul toute machine hyper optimisée de l'époque. Une anecdote pleine de sens à mon avis à l'heure où l'on souhaite orienter davantage la recherche française vers l'application (l'innovation comme on dit...)

A suivre ...

PS : pour ceux qui veulent en savoir un peu plus sur l'histoire de l'informatique, je conseille ce site.

quelques billets pour vous faire part d'une conversation amusante que j'ai récemment eue avec mon directeur de thèse (il me faut préciser pour les potentiels lecteurs de ce blog qui ne sont pas de mes proches que je suis en toute fin de thèse de physique et que je soutiens le 16 Septembre. Ugh...). J'ai vu dans ma prime jeunesse tout au long des années 80 et 90 l'essor de l'informatique personnelle (je me souviens encore avec excitation et émotion du jour où mon père a ramené à la maison un TO7). Je croyais naivement qu'avant cette époque glorieuse, l'informatique -en France en tous cas- n'était reservée qu'à une élite fortunée et/ou militaire et que de gigantesques machines type Eniac (cf photo) calculaient jour et nuit d'obscures quantités liées à une potentielle guerre nucléaire. Que nenni ! L'informatique avait déjà fait depuis longtemps son entrée dans les labos de recherche. Mon directeur de thèse a même été l'un des tous premiers à taper sa thèse sur traitement de texte, à l'aide d'un concurrent aujourd'hui disparu de Tex. Pour l'anecdote, l'ordinateur du labo auxquel étaient reliés tous les terminaux occupait la totalité de la salle où travaillent actuellement les thésards (faut-il y voir une certaine continuité historique 8^) ? ). Plus surprenant, jusqu'à assez récemment, l'un des défis potentiels était de concevoir et de construire des ordinateurs pouvant résoudre spécifiquement des problèmes très précis donnés. Par exemple, un ordinateur pouvant calculer précisément des comportements liés aux transitions de phase (type eau-glace) , ou pouvant simuler très efficacement tel ou tel problème de physique des fluides. L'idée séduisante était d'optimiser l'architecture et les langages pour pouvoir commercialiser et utiliser au quotidien un super-ordinateur pouvant réaliser une opération très précise donnée.

Evidemment, ces projets très lourds et très couteux sont vite devenus caducs compte-tenu de la croissance exponentielle des capacités de calcul. Dès le début des années 90, n'importe quel PC du commerce écrabouillait de plusieurs ordres de grandeur en terme de puissance de calcul toute machine hyper optimisée de l'époque. Une anecdote pleine de sens à mon avis à l'heure où l'on souhaite orienter davantage la recherche française vers l'application (l'innovation comme on dit...)

A suivre ...

PS : pour ceux qui veulent en savoir un peu plus sur l'histoire de l'informatique, je conseille ce site.

Aucun commentaire:

Enregistrer un commentaire